هوش مصنوعی و جامعهی الجیبیتی+

«هوش مصنوعی» یا Artificial intelligence که احتمال دارد مخفف آن یعنی AI را بارها شنیده باشید، پدیدهی نوظهوری است که نه تنها در حال حاضر زندگی ما را از بسیاری جنبهها تغییر داده است و امکان دارد نسبت به این تغییرات آگاه نبوده نباشیم، بلکه از آنجایی که روز به روز پیشرفتهتر و قدرتمندتر میشود، ممکن است آیندهی زندگی انسانها و کرهی زمین را به کلی دگرگون کند.

ارائهی تعریف دقیق از «هوش مصنوعی» ، هم به علت آنکه در حال تکامل است، هم به علت پیچیدگی خود آن و هم اینکه در حوزههای گوناگونی مورد استفاده قرار میگیرد، مشکل است.

اما شاید بتوان گفت هوش مصنوعی که عملکردهای «شناختی»، همچون «یادگیری» و «حل مسئله» را از روی ذهن انسانها تقلید میکند، عبارت است از مطالعهی اینکه چگونه رایانهها را میتوان وادار به کارهایی کرد که در حال حاضر هنوز انسانها آنها را بهتر انجام میدهند. بنابراین این حوزه که با دادههای کیفی انسانی و الگوریتمهای کمی ریاضی سروکار دارد، یک حوزهی میان رشتهای است که از کامپیوتر گرفته تا ریاضی، علوم تجربی، پزشکی، مهندسی، علوم شناختی، عصب شناسی و مغزشناسی، روان شناسی، جامعهشناسی، حقوق، سیاست، فلسفه و بسیاری از رشتههای دیگر را در برمی گیرد یا بر آنها اثر میگذارد.

امروزه کاربردهای بسیار متنوع AI را میتوان در بسیاری از حوزهها از جمله موتورهای جستجوی وب (نظیر گوگل)، سامانههای توصیهگر (که توسط یوتیوب، آمازون و نتفلیکس استفاده میشوند)، الگوریتمها در شبکههای اجتماعی به منظور مقابله با هرزنامهها (اخبار غلط)، تبلیغات تجاری و بالا بردن امنیت سیاسی، فهم زبان انسانها (همچون دستیاران، سیری Siri و الکسا Alexa یا پروژهی OpenAI و GPT3)، خلق آثار هنری و تولید محتوا، تشخیصهای پزشکی و روانپزشکی، آموزش و پرورش (مثلاً از طریق عینکهای واقعیت مجازی)، خودروهای خودران در صنعت حمل و نقل (نظیر تسلا) یا تسهیلات نظامی خودکار (مثل پهبادها) و تصمیم گیرهای خودکار، سامانههای بازیهای استراتژیک و فکری (همچون شطرنج و گو)، اثبات قضایای ریاضی، تعیین هویت از طریق تصاویر و صداها (تشخیص چهره و صدا)، شبیهسازی رفتارهای انسانی، ذخیرهی انرژی، رباتهای تولید کننده و خدمات دهنده در فروشگاهها و رستورانها، در زمینهی تجارت، اقتصاد و تحلیل کلان دادهها و حتی در تهیهی قراردادهای حقوقی و پیش بینی آرای قضایی، دنبال کرد.

بنابراین میبایست توجه داشت که هوش مصنوعی نه یک «راه حل» بلکه یک «ابزار» است و از آنجایی که هر نوعی از تکنولوژی یا فناوری، نوعی ابزار است، هوش مصنوعی نیز همانند تمامی ابزارهای دیگر، پرسشهایی نظیر آنچه در پی میآیند را پیرامون موجودیت خود بر میانگیزاند: «چگونه میخواهیم از آن استفاده کنیم؟» و «استفاده از آن میتواند چه اثرات مثبت و یا منفی (کوتاه مدت یا بلند مدت) بر انسانها، کرهی زمین و جاندارانی که در آن زندگی میکنند، بگذارد؟» «آیا هوش مصنوعی انسانها را تواناتر میکند و شغلهای جدیدی درست میکند و یا برعکس؟» «آیا سیستمهای نظارتی پیشرفتهی دولتی Surveillance Systems که در برخی از کشورها نظیر چین به نحو گستردهای از آنها استفاده میشود، نوعی دیکتاتوری نوین است؟» «آیا به فروش رساندن اطلاعات کاربران به قصد کسب سود اقتصادی و سیاسی به شرکتها عملی اخلاقی است و یا نقض آشکار حریم خصوصی است؟» «آیا هک شدن ذهن آدمی و کسب شناخت بیشتر از انسان (یعنی بیشتر از اینکه خودمان خودمان را بشناسیم، هوشهای مصنوعی ما را بشناسند) جای نگرانی دارد و بسیار خطرناک است؟» «آیا در آینده میشود مثلاً گرایش جنسی یا عقاید و احساسات را از دیگران یا سیستمهای نظارتی حکومتی پنهان نمود؟»

امروزه، فناوری هوش مصنوعی انبوهی از نگرانیها و پرسش ها را پدید آورده است و کنشگران مدنی در حوزههای مختلف را به فکر انداخته تا پیرامون «عدالت اجتماعی» و مفاهیمی نظیر «حقوق بشر» یا «آزادی» و «برابری» در دنیای دیجیتال امروز و آینده، تأمل کرده و با یکدیگر به گفتگو و مشورت بنشینند. ما در این مقاله، صرفاً بر موضوع «جنس و جنسیت» در روند دگرگشت (یا تکامل) هوش مصنوعی تمرکز خواهیم کرد و بازتاب سوگیریهای جنسیتی جوامع انسانی و امکان تشدید تبعیضها علیه زنان و اقلیتهای جنسی و جنسیتی را نشان خواهیم داد و همچنین ضرورت سیاستگذاریهای انسان محور و اخلاقی را در این حوزه بررسی خواهیم نمود.

سوگیری های جنسی و جنسیتی:

از زمانی که دانشمندان و متخصصین هوش مصنوعی با سوگیریهای نژادی و جنسیتی زیادی در روند رشد هوشهای مصنوعی مواجه شدند، اصطلاح Human centure کردن یا «انسان مرکز» کردن این تحقیقات در میان برخی از دانشگاهیان به وجود آمد و دغدغه شد. مرکزیت دادن به انسان در فناوریها به این معناست که میبایست علوم تجربی Science را طوری هدایت کنیم که به نیازهای تمامی انسانها یا دستکم هرچه بیشتر آنها پاسخ دهد. از آنجایی که انسانهای گونانی با هویتهای گوناگون و با فرهنگ و زبان و جنسیت گوناگون در سرتاسر جهان زندگی میکنند، فراگیری اطلاعات و مشارکت دادن تمامی هویتها در پیشبرد فناوریهای جهان شمول، نه تنها اخلاقی بلکه هم ضروری است.

ما در اینجا از مصادیق و مسائلی که مربوط به الگوریتمهای شبکههای اجتماعی هستند، نظیر اپلیکیشنهای دوست یابی یا همسریابی و یا همچنین از رباتهای انسان نمایی که جای معشوقه، همسر یا شریک جنسی را میگیرند و اثراتی که چنین فناوریهایی بر روان و جامعهی انسانی خواهند گذاشت، میگذریم و در عوض توجه شما را به این موضوع جلب میکنیم که با توجه به تغییر معنای مفاهیم و از آن جمله «جنس» و «جنسیت» در طول تاریخ و به خصوص در چند دههی اخیر و متمایز شدن انواع گرایشهای جنسی، هویتهای جنسیتی و بیان جنسیتی و همچنین گسترش و جایگزینی نگاه طیفی spectrum به جای نگاه دوقطبی یا باینری Binary (یا مرد یا زن) ، امروزه شاهد حجم وسیعی از «سوگیریهای جنسیتی» Gender bias در هوشهای مصنوعی هستیم. هوش مصنوعی امروز خودش جنسیت ندارد اما سوگیریهای جنسیتی دارد.

از آنجا که برای هزاران سال فرهنگ غالب جوامع بشری، مردسالارانه patriarchy ( و زن ستیز Misogyny) بوده است و همچنین تبعیضها و ستیزها علیه هویتهای مختلف همواره وجود داشته است، هوشهای مصنوعی که با اطلاعات Data گذشته، یعنی بر اساس اطلاعاتی که ما به آنها میدهیم کار میکنند، نه تنها این سوگیریها را بیش از پیش به ما نشان میدهند بلکه وقتی قرار بر «تصمیم گیری» باشد و بخواهند خودشان با عاملیت خودشان منشأ اثری بر جوامع انسانی شوند، بر اساس همین سوگیریها عمل کرده و در نتیجه آنها را بازتولید و حتی تشدید نیز خواهند کرد.

هوشهای مصنوعی برای تصمیم گیری از فاکتورها یا عواملی استفاده میکنند که انسان ها در روند تصمیم گیری خودشان توانایی در نظر گرفتن آنها و محاسبه کردنشان را ندارند. به زبان ساده، نحوهی تصمیم گیری کامپیوتر یا ماشین با انسانی که عواطف و باورهایش نقش عمدهای در عملکردهایش ایفا میکند، فرق دارد. مثلاً یک مأمور بانک ممکن است از ظاهر کسی یا گرایش جنسی او خوشش نیامده و وام را به درخواست کننده ندهد اما اگر برای هوش مصنوعی تعریف شود که گرایش جنسی ارتباطی به خوش حسابی افراد ندارد، این عامل را دخالت نخواهد داد. در مورد استخدام کردن یا شناسایی مجرمین نیز وضع به همین صورت است. به عنوان مثال، در آمریکا به دلیل آنکه دادهها نسبت به سیاهان دارای سوگیری بودهاند، امروزه نیز هوشهای مصنوعی تکامل یافته با این دادهها، سوگیریها را در تشخیص جرم بیشتر نشان میدهند. پس اینکه ما چگونه این اطلاعات را تعریف کنیم یا به اصطلاح چه کدی برایشان بنویسیم، اهمیت بسیار زیادی دارد. زمانی که هنوز بر سر معانی و سیاستهای کاربردی اتفاق نظر وجود نداشته نباشد، ماشین یا هوش مصنوعی کمکی به ما نمیتواند بکند. مثلاً این روزها بحث (اگر نگوییم جنگ!) در مورد هویت افراد ترنسجندر داغ است و حتی دولتمداران و شخصیتهای مشهور، راجع به اینکه «آیا یک زن ترنس، یک زن است؟» نظرات مختلفی را ارائه میدهند که بعضاً با یکدیگر متضاد نیز هستند. پس برای متخصصین حوزهی هوش مصنوعی بسیار اهمیت دارد که متخصصان از حوزههای مختلف مثل فمینیستها، اقلیتهای جنسی و جنسیتی، سیاستمداران، جامعه شناسان، روان پزشکان، فیلسوفان و حتی افراد بدون تخصص نیز نظرات خودشان را منعکس کنند تا در یک کار جمعی بشود نقشههای راهی برای این کودک نوپا ترسیم نمود و درواقع آن را تربیت کرد. مثلاً میشود تلاش کرد تا به این سوال پاسخ داد که «آیا جنسیت یک امر سیال Fluidity است؟»

امروزه مثلاً در فناوریهای تشخیص چهره، تقریباً تا صد در صد افراد نان باینری یا کوئیر، Misgender شده یا هویتیابی نمیشوند یا اینکه مسیرهای اشتباهی رفته شده است. به عنوان مثال، تشخیص گرایش جنسی از روی چهرهی افراد که رویکردی Tokenism یا «نشانه گرا» است، میتواند تبعات و خطرات زیادی در آینده داشته باشد و به سوگیریها و قضاوتهایی که سبب تبعیض یا حتی نفرت و ستیز در جوامع میشود، دامن بزند. برای همین، عدهای از فعالین حامی حقوق زنان و حقوق الجیبیتیکیوآیپلاس یا دانشمندان و متخصصانی که خودشان زن یا کوئیر هستند، وجود دارند که که از ضرورت مشارکت گروههای مختلف و به حاشیه رانده شده در علوم تجربی و صنعت تکنولوژی سخن به میان میآورند. آنها میگویند اینکه مثلاً سیری اسم یا صدایی زنانه دارد اما برنامهها را اکثراً مردان نوشتهاند، کافی نیست و درواقع حاکی از بازتولید مردسالاری و تبعیض جنسیتی است. برای فناوری تشخیص صدای اکثریت انسانها، باید نمونههای بسیاری داشت و برای رسیدن به این منظور، مشارکت حداکثری این گروهها در روند رشد هوش مصنوعی ضروری است.

اصطلاحاتی وجود دارد نظیر Trans Science (دانش ترنس) یا Queering Ai (کوئیرکردن هوش مصنوعی) که ضرورت سیاستگذاریها در این خصوص را برجسته میکنند و رشتههای مطالعاتی نظیر Gender norms And Politics (هنجارهای جنسیتی و سیاست) نیز وجود دارند که به بررسی این موضوعات میپردازند. همچنین سازمانهای جهانی و حقوق بشری مانند سازمان ملل متحد UN یا یونسکو Unesco نیز از همکاریهای جهانی در زمینهی فراگیر کردن هوش مصنوعی حمایت میکنند و برای برنامهی توسعهی پایدار و سند۲۰۳۰ نیز ضروری دانستهاند.

هوش مصنوعی و ضرورت گنجاندن هویتهای مختلف و از جمله خانوادهی رنگین کمانی برای رسیدن به عدالت، فراگیری و برابری بیشتر:

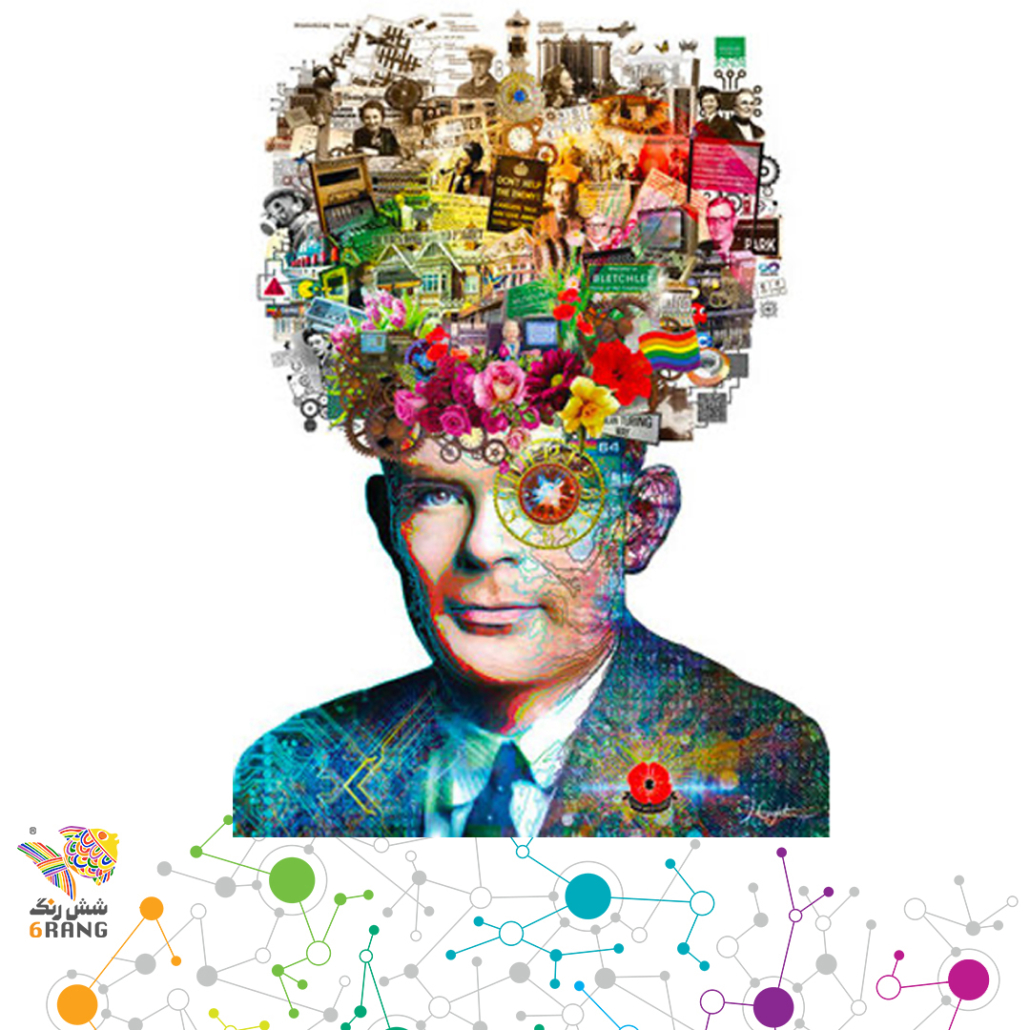

جالب است بدانید که یکی از مهمترین دانشمندانی که در پیشرفت هوش مصنوعی سهیم بود «آلن تورینگ» Alan Turing بود که به پدر علم کامپیوتر و هوش مصنوعی نیز معروف است. او در زمان زندگی خود، به خاطر آشکارا همجنسگرا بودن، ستیزهای دولتی و فرهنگی زمانهاش را تحمل کرد و تجربهی زندانی شدن و درمان اجباری را داشته است. تورینگ از آزمایش معروفی صحبت میکند که در سال ۱۹۵۰، در نوشتهای به نام «محاسبات ماشینی و هوشمندی» مطرح کرد و امروزه به نام «آزمایش تورینگ» شناخته شده است. در این آزمون شرایطی فراهم میشود که انسان با ماشین تعامل داشته باشد و پرسشهای کافی برای بررسی اقدامات هوشمندانهی ماشین را از آن بپرسد. چنانچه در پایان آزمایش نتواند تشخیص بدهد که با انسان یا با ماشین در تعامل بودهاست، آزمون با موفقیت انجام شدهاست. تاکنون هیچ ماشینی از این آزمون با موفقیت بیرون نیامده است. کوشش این آزمون برای تشخیص هوشمندی یک سامانه است که سعی در شبیه سازی انسان را دارد.

پس جامعهی الجیبیتیکیوپلاس حتی از همان ابتدا بخش مهمی از فناوری هوش مصنوعی بودهاند. اما جدا از بحث ضرورت حضور دانشمندان متعلق به این جامعه در روند رشد دانشها و علوم تجربی، آیا این فناوری میتواند به عموم خانوادهی رنگین کمانی کمک کند یا قرار است تبعیضها را علیه آنها تشدید کند؟

در مجموع میتوان گفت بستگی به خود ما دارد! با وجود اینترنت و گردش سریع اطلاعات کمتر متمرکزگرا در هوش مصنوعی که به نحوی در دسترس همگان هست و روی تمامی جوامع انسانی، فارغ از تفاوتهایشان اثر میگذارد، این فناوری ماهیتی دموکراتیک دارد. پس از این جهت برای اقلیتهای جنسی و جنسیتی هم مانند سایر شهروندان امکاناتی به وجود آمده است. مثلاً بعد از بحران همهگیری کرونا که بسیاری از افراد شروع به کار کردن در خانه کردند، شاید برای برخی از اعضای این خانواده نیز که خیلی از آنها «سندورم خود کم بینی در کار» Imposter Syndrome را نیز تجربه میکنند، فرصت شغلی ایجاد شده باشد یا به دلیل آنکه نیاز به حضور اجتماعی نداشتهاند، احساس راحتی بیشتری داشته بوده باشند. همچنین به نظر میرسد زندگی بیشتر در شبکههای اجتماعی، در جهت آگاه سازی عموم مردم نسبت به این جامعه به همراه قانونهای تسهیلی در برخی از کشورها، «آشکارسازی» را بیشتر کرده است که این نیز از جنبههای مثبت ماجراست. اما از طرف دیگر تبعیض، آزار و اذیت (Bolling) و داغ ننگ (Stigma)هایی که حتی هنوز نیز در کشورهای به اصطلاح پیشرفتهتر وجود دارد، این جامعه را با فکر خودکشی، طرد شدن از خانواده، مشکلات در محیطهای آموزشی و اجتماعی، نداشتن امید و مشکلاتی در سیستمهای بهداشتی و پزشکی مواجه میکند. در بحرانها افراد آسیب پذیر بیشتر هم آسیب میبینند. بنابراین یکی از کاربردهای هوش مصنوعی به نفع اقلیتها میتواند در راستای کمک کردن و حمایت کردن از جوامع به حاشیه رانده شده و تحت ستم باشد. با الهام گرفتن از این اطلاعات، پروژههایی چون Trevor Project تلاش دارند تا مشخصاً به جوانان الجیبیتیکیوآیپلاسی که در بحران هستند کمک کنند. در این روزگاری که «سرعت» بالا نوعی ارزش حیاتی پیدا کرده است، هوش مصنوعی هم میتواند نقش حیاتی ایفا کند. مثلاً آنها در این پروژه، میتوانند پیغامهای درخواست کمک را توسط الگوریتمهای تعریف شده تحلیل کرده و ده دقیقه سریعتر از انسانها، متوجه خطر شوند. بنابراین آنها از هوش مصنوعی برای تشخیص اینکه کدام پیغامها را باید به دیگری اولویت داد (مثلاً اگر امکان خودکشی وجود داشته باشد)، کمک میگیرند.

جمع بندی:

از آنجایی که هوش مصنوعی در مرحلهی تکامل است و چون انسانها از مفاهیم، معانی متفاوتی برداشت میکنند و از آنجایی که قرار است این فناوری به زندگی عاطفی و اجتماعی و به تبع آن سیاسی ما وارد بشود، نگرانیهایی به وجود آمده است. مثلاً میشود پرسید که «آیا رنج را میتوانیم اندازه گیری کنیم؟ و رنج یک فرد را با دیگری از طریق آمار و ریاضی مقایسه کنیم؟» «آیا اساساً میشود کیفیت را با کمیت نشان داد و تعیین نمود؟ و یا نوعی تقلیل دادن و ماشینی کردن امور است؟» «آیا «همدلی» کردن قابلیتی است که مخصوص انسانهاست و یا در آینده شاهد حضور رباتهایی خواهیم بود که عاطفه را هم تجربه میکنند؟ و از این طریق دارای حقوق میشوند؟» اینها سوالات سرگرم کنندهای هستند که معطوف به آیندهاند و پاسخهای قطعی قابل پیشبینی ندارند اما ما قطعی میدانیم که در حال حاضر، دنیایی داریم که همچنان مردسالار است و نگاه بدون انعطاف نسبت به دوقطبی زن و مرد و نگاه سنتی به خانواده و ازدواج دارد و همچنین خود زبان انگلیسی و زبان باینری کامپیوتری که زبانهای جهانی شدهاند نیز به تداوم این جریانهای تبعیض جنسیتی دامن میزنند.

چنین مشکلاتی را خود هوش مصنوعی حل نمیکند و تغییر نمیدهد و حتی امکان دارد اگر بازبینی نشوند آنها را تشدید هم بکند. این هوش مصنوعی که ما امروز میشناسیم احساس ندارد و احترام گذاشتن برایش معنا ندارد این انسانها هستند که میبایست ضرورت اخلاق و صلح طلبی را در علم و تکنولوژی و صنایع نشان داده و آنها را هدایت کنند. بنابراین لازم است که همواره به هر نوع ابزار و فناوری نگاه انتقادی داشته باشیم. همچنین روایتها و داستانها در معنادادن و جهت دادن به تکنولوژی مهم هستند. بنابراین خانوادهی الجیبیتیکیوآیپلاس نیز میبایست با «مشاهده شدن» و حضور، چه در قالب تولید کننده و متخصص و چه در قالب مصرف کننده، داستانهای خودشان را روایت کنند و «تکثر» را که لازمهی جوامع عادل است، به همراه دیگر هویتهای تحت ستم به این فناوری انقلابی وارد کنند و در روند رشد و تکامل آن مشارکت داشته باشند.

همچنین عموم انسانها نیز با آگاهی اینترسکشنال و رویکرد تقاطعی میتوانند سوگیریها را چه در سطح فرهنگی، چه سیاسی و چه تکنیکی کاهش دهند و در مشارکت دادن فراگیر همه گونه انسان و جوامع به حاشیه رانده شده، مفید واقع شوند. این فراگیری میتواند هم در قالب اطلاعات ورودی باشد، هم از جهت مشارکت دادن متخصصین متعلق به این خانوادهها تا نمایندهای برای کل جامعهشان باشند و نیازهای این گروه را بازتاب دهند و هم از جهت توجه به مصرف کنندگان متعلق به جوامع تحت ستم و فناوریهای پزشکی و آموزشی مخصوص آنها و تفکر پیرامون اثرات منفی یا مثبتی که میتواند هوش مصنوعی بر این جوامع به حاشیه رانده شده و از جمله اقلیتهای جنسی و جنسیتی بگذارد.

در قسمت بعدی، بخشی از گفتگوی من با هوش مصنوعی Gpt3 پیرامون مسائل مربوط به «جنس و جنسیت» و «اقلیتهای جنسی و جنسیتی» به زبان فارسی خواهد آمد.

کیومرث منطقی

دیدگاه خود را ثبت کنید

تمایل دارید در گفتگوها شرکت کنید؟در گفتگو ها شرکت کنید.